29 Apr, 2021

29 Apr, 2021

Gia tốc của Big Data

Một người phát triển viết cho tôi: “Em thích blog của thầy về Big Data. Em hiểu khối lượng của Big Data; sự đa dạng của dữ liệu như có cấu trúc và phi cấu trúc, nhưng em không hiểu vấn đề gia tốc – velocity. Xin thầy giải thích.”

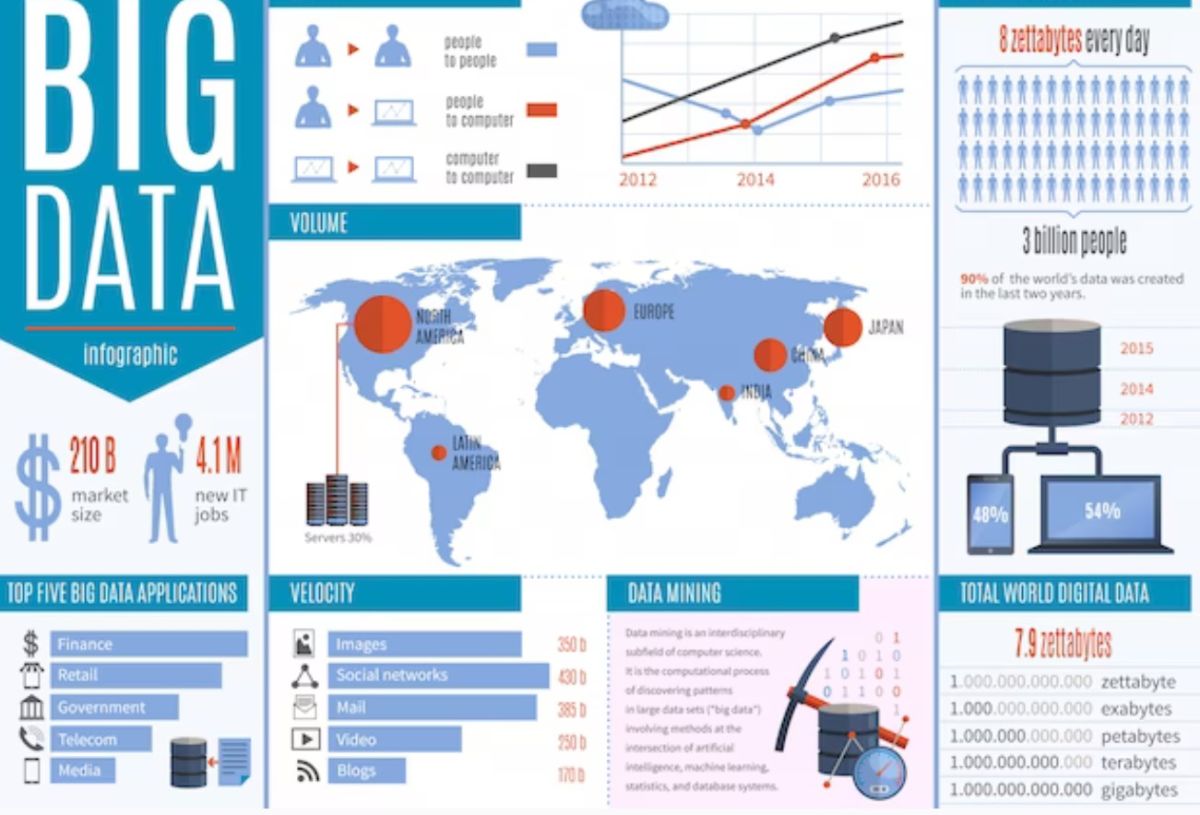

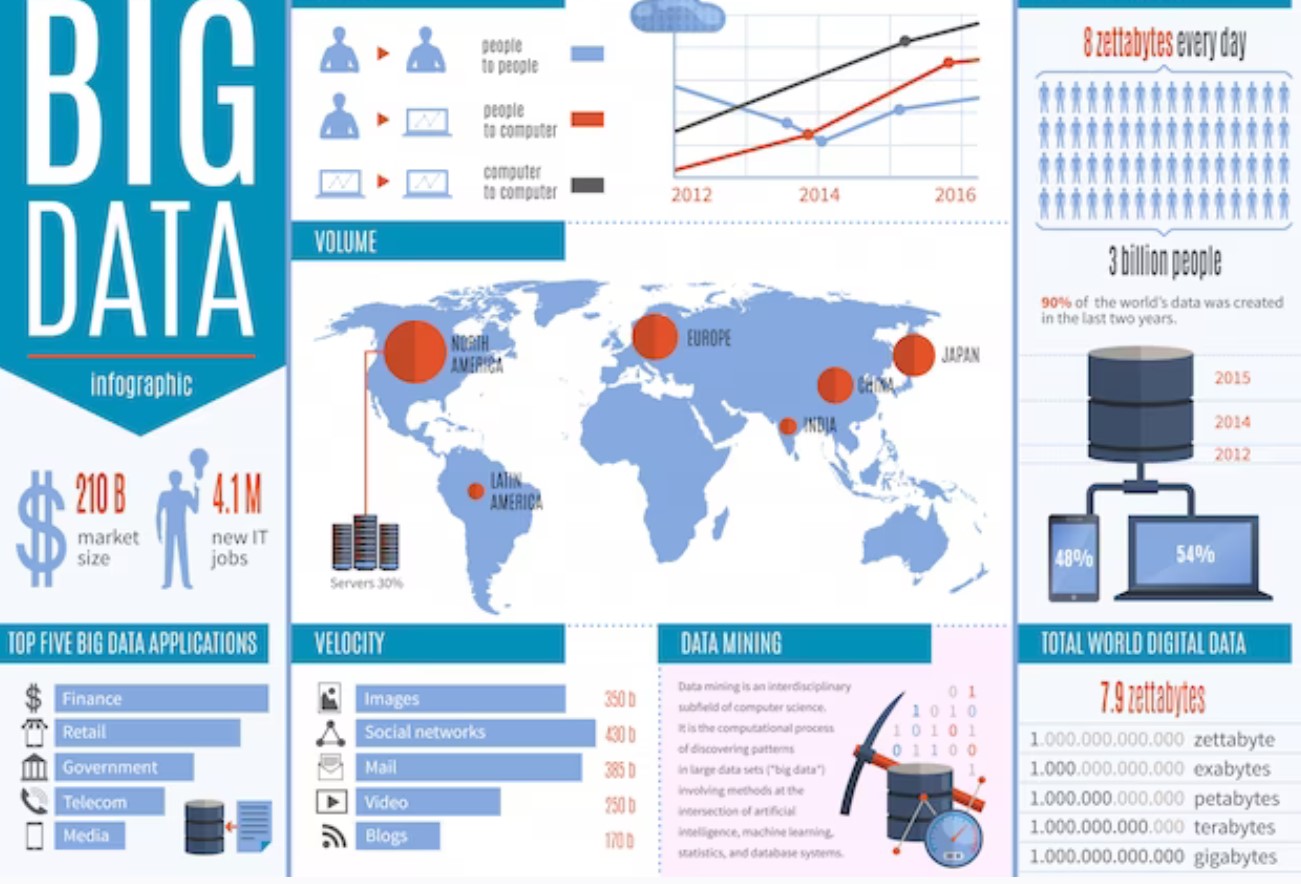

Đáp: Có ba yếu tố then chốt của Big Data (Ba chữ V: Volume, Variety và Velocity.) Velocity – gia tốc – nghĩa là dữ liệu thay đổi và tăng trưởng nhanh. Nó ngày càng lớn lên theo thời gian. Chẳng hạn, mọi người thêm dữ liệu vào trong websites của họ mọi lúc và nó tăng lên nhanh chóng. Các giao tác thị trường chứng khoán chuyển hàng tỉ hay nghìn tỉ đô la cứ vài giây. Các cảm biến thời tiết đo thay đổi về nhiệt độ cứ vài phút. YouTube thêm các luồng video cứ năm phút một. Không chỉ những dữ liệu này yêu cầu bộ nhớ lưu giữ khổng lồ mà nó thay đổi nhanh thế và làm cho việc phân tích thành khó thế. Bạn phải thu thập và phân tích nhữn dữ liệu này theo “thời gian thực” nếu không nó mất nghĩa. Chẳng hạn, nếu bạn giám sát xu hướng thị trường chứng khoán dựa trên dữ liệu ngày hôm qua thì bạn có thể bỏ lỡ cái gì đó do thông tin “lạc hậu” của bạn.

Thách thức của Big Data, không chỉ ở tính lớn khổng lồ, với đủ mọi kiểu dữ liệu, nhưng nó cũng thay đổi rất nhanh. Nếu bạn không thể thu thập, kiểm soát, phân tích và ra quyết định về nó thì ai đó sẽ làm. Trong kinh doanh cạnh tranh toàn cầu này, đó là khác biệt giữa người thắng và kẻ thua. Các nhà phân tích dữ liệu lớn phải hỏi những câu hỏi này: Chúng ta phân tích các dữ liệu này thường xuyên thế nào? Cứ mười phút? Hàng giờ? Hay hàng ngày? Khi nào dữ liệu là không hợp thức? Chúng ta sẽ làm gì với dữ liệu lạc hậu? Làm sao chúng ta biết?

—English version—

Velocity of Big Data

A developer wrote to me: “I enjoy your blogs on Big Data. I understand the volume of Big Data; the variety of data such as structured and unstructured, but I do not understand the velocity issue. Please explain.”

Answer: There are three key elements of Big Data (The three V: Volume, Variety and Velocity.) Velocity means the data changes and grows fast. It is getting bigger and bigger with time. For example, people add data into their websites all the time and it grows quickly. Stock market transactions move billion or trillions of dollars every few seconds. Weather sensors measure change in temperature every few minutes. YouTube adds streaming videos every five minutes. Not only these data requires huge storage but it changes so fast and makes the analysis so difficult. You must collect and analyze these data in “Real time” or else it loses the meaning. For example, if you monitor stock market trends based on yesterday data then you may miss something due to your “out of date” information.

The challenge of Big Data, not just it is huge, with all types of data, but it is also changing very fast. If you cannot collect, control, analyze, and make decision on it then somebody will. In global competition business, that is the difference between winner and loser. Big data analysts must ask these questions: How often do we analyze these data? Every ten minutes? Every hour? Or every day? When is the data being invalid? What are we going to do with out of date data? How do we know?

Thông báo

Thông báo

Quay lại đăng nhập

Quay lại đăng nhập